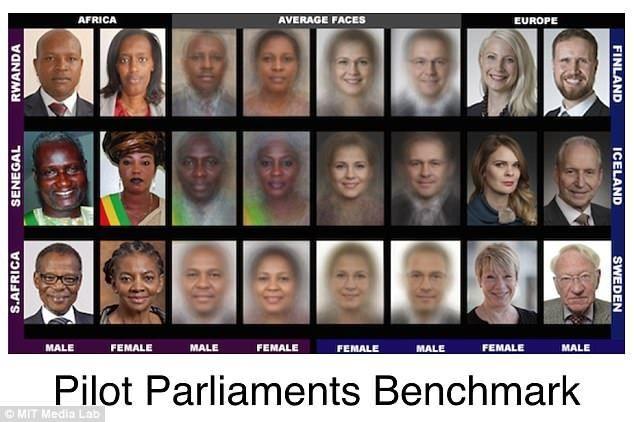

导读:微软发现,商用人脸识别识别肤色较浅的男性准确率最高,而失误率最严重的是肤色较深的女性。在演唱会“抓逃犯”上屡建奇功的人脸识别,其实还是不成熟的技术,具体表现在对肤色和性别的歧视上。

微软发现,商用人脸识别识别肤色较浅的男性准确率最高,而失误率最严重的是肤色较深的女性。在演唱会“抓逃犯”上屡建奇功的人脸识别,其实还是不成熟的技术,具体表现在对肤色和性别的歧视上。

微软发现,商用人脸识别识别肤色较浅的男性准确率最高,而失误率最严重的是肤色较深的女性。这可算是人脸识别的“技术偏见”了。

这种偏见一旦在大范围应用中“显现”,声讨种族和性别“歧视”的声音,将会淹没微软。为了解决充满偏见的技术,微软 Face API 团队对其识别系统进行了三次重大改进。最新的人脸识别系统,识别肤色较深的人错误率降低了 20 倍,识别所有女性的失误率减低了 9 倍。

尽管有了改进,但目前的人脸识别,还不是完美的系统。微软认为,问题的根本解决办法还是训练数据库,需要收集更多的数据,包括不同肤色、发型和面部饰品等。

中国人普遍的黄皮肤,刚好避开了“最浅”和“最深”的肤色。但我国也有外貌特征各异的少数民族,如果人脸识别对此产生技术偏见,就不是简单的“开地图炮”了,可能会引发严重的民族矛盾。

至于“更大范围攻击”的性别歧视话题,在我国也变得非常敏感,该庆幸人脸识别技术目前还没有惹来“性别歧视骂战”。

偏见的锅不能完全甩给人工智能,技术也是反映真实社会的镜子。

微软研究实验室的高级研究员、AI 系统公平性专家Hanna Wallach在一份声明中回应:如果我们训练机器学习系统使用有偏见的社会产生的数据,来模拟那个社会做出决定,那么这些系统必然会重现它的偏见。

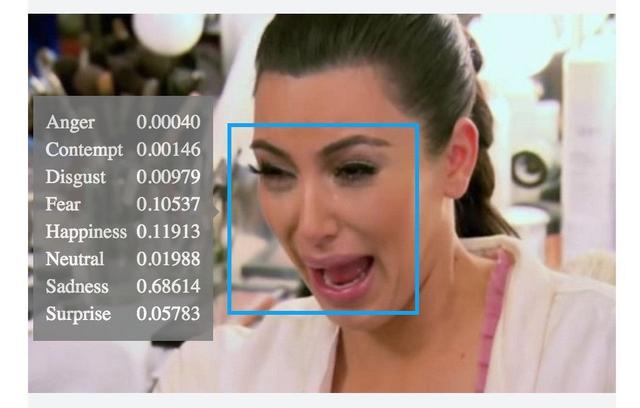

例如,在一些社区中,黑人的犯罪率更高,AI 根据收集来的数据,更容易把肤色较深的人划分到“逃犯”的分类中。这是群体给个体的伤害,人脸识别只不过“遵循了”社会偏见。

相比起导致“歧视”,研究团队更希望 AI 能检测和减轻偏见,以弥补现实社会中的不完美。追捕逃犯用大范围攻击的“种族炮”和“性别炮”容易伤及无辜,人脸识别的方向是更精密的“狙击枪”。

一直对人脸识别技术保持警惕的美国,其海关部门也要启用人脸识别系统,但收到强烈的反对。