导读:本文从需求、技术角度聊聊5G的愿景、技术,简单谈谈作者对这些技术的理解。

图片来自“东方IC”

现在,普通用户对5G充满希望,许多人认为它将是一场变革——改进的用户体验、新的应用、新的商业模式和新的服务将伴随着千兆比速率、低延迟、大容量、低能耗更加先进的网络性能和可靠性应运而生。

然而,运营商和一些通信行业人士却对商业案例持怀疑态度——5G技术尚不成熟、部署5G需要大量投资,警告声不绝于耳。ITU发布的报告中曾估计,在假设光纤回程在商业上可行的情况下,5G部署成本可从小城市的680万美元到人口密集大城市的5550万美元不等;而单站的部署成本大约在20000美元到50000美元之间(注:这里提到的成本是投资成本CAPEX,不包含长期运维成本)。

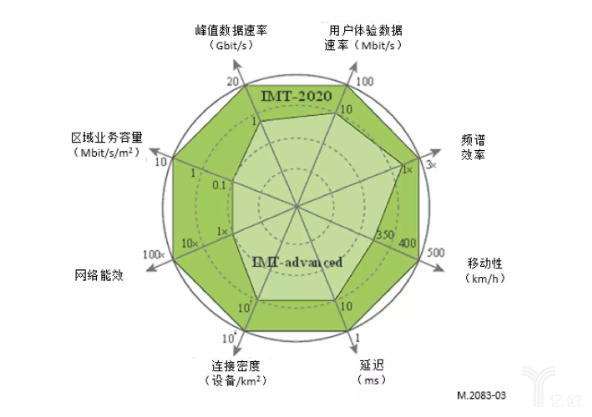

国际电信联盟(ITU)在2015年9月发布M.2083-0号建议时(面向2020年及之后的国际移动通信结构和目标),时任电信发展局主任的布哈伊马?萨努就已经意识到他们正在揭开一场波澜壮阔却又争议丛生的通信行业新篇章。

不过他或许没有想到的是,在4年后的今天,5G会成为人工智能以后又一个热点,引来全民讨论和追逐,引来大国战略博弈,甚至因此催化了5G商用步伐。

有人欢喜,有人忧虑,有人觉得充满前景,有人认为会彻底失败,众说纷纭。每个人都有自己的坚持,本文将从需求、技术角度聊聊5G的愿景、技术,简单谈谈作者对这些技术的理解。

自从人类社会诞生以来,如何高效、快捷、可靠地传输信息始终是人类矢志不渝的追求。从文字到印刷术,从欧洲古老的光信号塔到现代无线电,从手工转接电话到宽带移动互联网,可以这么认为,现代科技发展速度一直被信息传播速度所直接影响。从这个角度来看,现在商用移动通信网络或许能被称作全球信息传播系统中的最重要组成部分。

它的影响潜移默化,时至今日虽然很多人都因为信息爆炸而憧憬车马邮件都慢的古铜色历史,但如果真的没有网络,没有信号,我想大部分人的工作和生活都会无法正常进行。

与此同时,有一种观点这么认为,移动通信系统现象级的成功主要来自于极为快速的技术创新和迭代。从20世纪70年代初贝尔实验室研制出第一代移动通信系统(先进移动电话系统,AMPS)到21世纪初的第四代移动通信系统,移动通信系统已经完成了从模拟通信到数字通信、从纯电路交换到全IP交换、从CDMA到OFDM的数次技术更新,每一次更新都带来了更快的速度、更低的延迟和更多的特性,也带来了更好的用户体验。

实际上,为了统一全球通信标准以方便用户国际漫游等需求,自从3G以来,ITU一直致力于从各地区的工作小组和工作论坛中搜集整理未来通信行业需要解决的问题,并每十年左右发布一次官方建议文件,作为此代通信系统的设计目标,并从全世界收集符合该目标的技术标准,这些标准通常由类似3GPP或者IEEE的组织制定提交,由ITU验证评估。

可以认为这些快速迭代的建议目标是符合当下未来十年的通信需求的。当然,因为商业和政策问题,当存在竞争标准时,符合这些目标的标准集合不一定会完全成功,两个非常典型的例子就是TD-SCDMA和WiMax。

一些数据可能能够说明问题:

截止2016年底,LTE系统已经覆盖了21.7亿人,包含世界上大部分国家地区 ,连接数几乎以每年翻倍的势头增长,2015年LTE的连接数达到十亿,预计到2021年可能达到43亿。如果想要用LTE系统同时服务物联网设备,那么2022年左右总连接数可能达到180亿,这已经完全超过了当前LTE系统的负载能力。

当然,一种比较简单粗暴的想法是直接增加基站,但是这样做又会带来很多新问题:在4G(IMT-Advance)的设计目标里,并没有考虑能耗和二氧化碳排放量等等问题;虽然3GPP提出的LTE系统有考虑物联网设备,但是物联网本身的关键性能也没有在4G的设计目标占据一席之地;更加严重的问题是,因为4G中技术选型、调制方式设置和单载波频带宽度等等问题,4G网络已经达到它设计之初的理论速度上限[2],与之类似的还有频谱利用率,移动性,服务质量等等指标。

当房子里的住户每次走进房门都需要考虑是不是撞到头的时候,或许就是考虑换个门的时候了。

因此,ITU在2015年提出了新的IMT-2020目标,5G拉开了序幕。

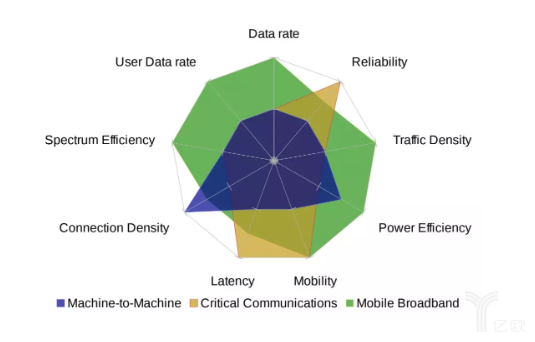

IMT-2020是第五代移动通信系统的需要满足的目标。单纯就IMT-2020来说,其增强型移动宽带的峰值数据速率需要达到10Gbit/s,在某些场景下需要支持20Gbit/s的峰值数据速率;用户有望体验到的带宽达100Mbit/s;整个网络的能耗应当比现存的IMT-advanced系统低100倍;无线往返延迟<1ms;支持500km/h的高移动性服务等等;同时划分了三个重要场景增强型移动宽带(eMBB),海量机器通信(mMTC)和超可靠低延迟通信(URLLC)。

当IMT-2020建议发布之后,ITU就当了甩手甲方,坐等验收了。那么如何组织各项无线通信技术来构成一个系统来满足5G目标,怎么设计这个通信系统就甩给了3GPP和IEEE等标准化组织。

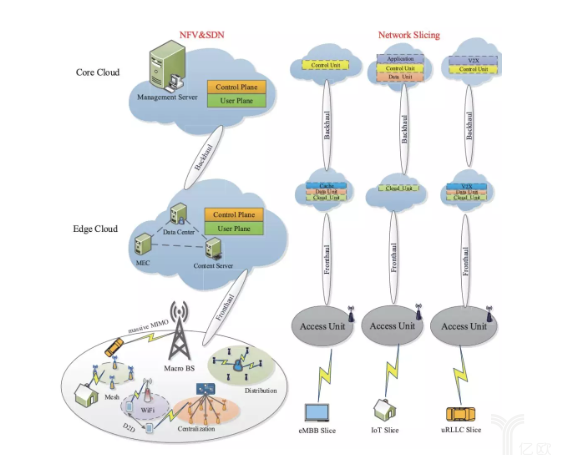

5G中为了使网络虚拟化,在接入网采用了C-RAN技术,它将基站控制单元放置在基带池中,那么基带池就成为了一个天然的小型数据中心。这样的小型数据中心有能力为基站池所服务的范围内用户提供一些计算/储存等缓存,如果部署在基站附近,或者就是某些基站本身,这种方式我们成为边缘计算。

4G本身是比较成功的,它已经建立了一个技术底线,那么怎么从浩如烟海的通信理论中找到可用的技术方案,据此提出标准提案,并让所有这些标准组合起来的整个系统性能可以达到ITU目标呢?更重要的是,要同时实现公司利益最大化?这或许是15年8月以来让加入3GPP的各大公司最头疼的事儿了。

不同公司有不同的选择:有实力的通信公司会选择自己预研先进的通信技术,预先布局,然后根据自己的技术积累做出提案,而没有实力做太多预研的公司,或许需要考虑自己的利益最大化来选择提案支持。

不过总体来说,有那么几种新技术是大家都看好的,就是很多文章都有提到的:

毫米波(mmWave),大规模天线(massive MIMO),网络虚拟化(NFV)/切片,改进的OFDM调制方式,Polar码,边缘计算,C-RAN。

同时,优化4G系统也衍生出了很多新的设计方案,所以从目前(Rel 15)来看,整个5G的调整是这样的(如下表):

注:边缘计算、C-RAN目前并未在Release 15中定义。

我想如果详细解释这些技术和调整,需要从头讲起。

无线通信的最重要的任务之一是获得更快的传输速度。对于此,我们有一个非常简单的衡量指标:任何通信系统的信道容量(最大数据传输速度)总是可以通过香农公式和信道容量来描述。

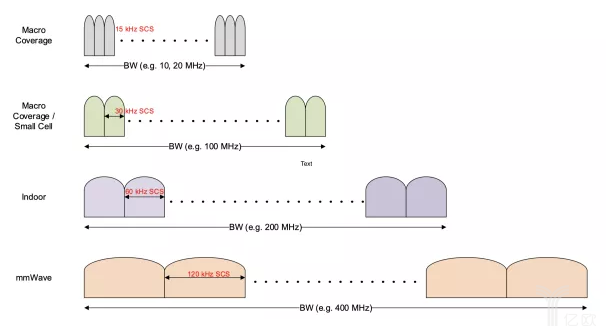

那么很自然的,我们始终可以通过提高无线电的频带宽度和信噪比两种指标来获得更快的传输速度。为此,移动通信系统的单载波带宽从2G时代的200kHz,发展到3G时代的5MHz,4G时代的20MHz(可变),直到现在3GPP 5G Release15中支持最大单载波带宽400MHz(可变)。

注:当前eMBB场景中sub 6G基站(就是目前正在商用的非毫米波基站)推荐使用的是100MHz单载波带宽。

而实际上,运营商从无线电管理部门的频谱宽度不可能刚好是20MHz(4G)或者100MHz(5G)这样的单载波带宽。比如移动在4G时代就曾获得1880 -1900 MHz(Bands:39)、2320-2370 MHz(Bands:40)、2575-2635 MHz(Bands:41),它们的频带宽度分别是20MHz,50MHz,60MHz。

这样的现实情况结果是运营商可以选择在自己的频带上同时传输多个载波。这些载波可以服务不同的用户来提高小区容量,也可以同时服务一个用户来提高单用户峰值速率。

当n个单载波服务一个用户时,用户能获得的频带宽度就是单载波带宽的n次倍,这样用户体验到的速度也能提高n次倍。这就是另外一种通过提高带宽,提高用户速率的手段载波聚合。

所以在4G后期,出现了很多通过支持三载波聚合获得高达600Mbps传输速度的LTE-A基站和手机终端。在5G中,载波聚合会因为可变帧参数得到更广泛的应用,比如可以将用于毫米波的400 MHz (@120 kHz)载波与用于sub 6G的100 MHz (@ 30 kHz)载波聚合,获得更快传输速度。

正如我们之前所说,一种提高数据传输速率的方式是增大频带宽度,但是现实中会面临一些囧境:现有的商用无线电频段(300MHz-3GHz)因为穿透性好,覆盖范围大而太过于拥挤,这部分频段经很难找到闲置的频谱用来通信。

所以现有的方式就是往3GHz以上寻找可用频段,而3GHz以上可用的频谱之一就是毫米波频段了。从长远来看,抛弃我们毫米波频谱中两个特殊的部分:氧气吸收和水蒸气吸收频谱,剩余部分带宽(252GHz)也远远大于现存的1-4G商用频谱之和(3GHz),足以满足未来带宽的需求。

固然毫米波频段有大量频谱可供使用,但是依然遇到了一些基础性问题:电信号在传播的过程中会遭遇非常严重的路衰和雨衰,因此毫米波一般只能用于视距通信,无法承受遮挡,而且在多障碍物的室内会引发严重的多径效应。

注:多径效应的后果是接收机难以分清信号主径,在这种情况下,不同路径的信号会因为到达时间不同,产生相互干扰,降低接收机信噪比。

同时,毫米波频段因为接近氧气和水蒸气吸收频段,人体会对毫米波频段信号传播产生很大衰减。这种情况下当手机内部天线放置不当时,即使手握手机也会显著影响信号质量,这对手机厂商的毫米波天线设计方案也带来了挑战。此外,毫米波芯片功耗比较大,射频和天线部分都有较明显的设计难题,目前国内的部署方案主要采用sub6G频段完成5G覆盖,毫米波覆盖主要在美国等国家进行。

虽然毫米波频谱利用有很大挑战,但是目前毫米波频谱需要被用于5G通信已经成为业界共识。主要原因是如果想要完成5G通信中高速数据传输目标,毫米波频段的使用是重中之重。因此业界一直在积极探索可能性和现实性。

早在2016年初,3GPP、美国联邦通信委员会(FCC)、欧盟委员会无线频谱政策组(RSPG)、中国工信部和韩国、日本、澳大利亚、加拿大、新加坡等国均开展了针对毫米波频段的规划及测量研究。在目前公布的3GPP R15中,由3GPP RAN4工作组分配及定义了52.6GHz以下频谱,而100GHz以下的频谱将在今年年底的R16中分配完成。

不过,目前针对毫米波频段的使用还存在另一大争议,24GHz附近的n258频段可能会对射电天文和天气预测等设备产生一定干扰,可能会影响到卫星通信、太空探测和气象预测等业务。根据ITU在2018年底TG 5/1工作组的无线电兼容共存报告,对于射电天文业务,23.4GHz-24GHz频谱应设立34-52公里的保护间隔,可以限制干扰。

但是即使如此,n258频谱的分配也因此在美国遭到了商务部和美国航空航天局(NASA)的强烈反对。

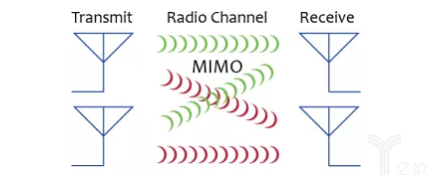

为了提高空域增益,信号发射端(例如基站)可以部署多天线系统,并让每个天线独立发射信号,同时在接收端用多个天线接收并恢复信息,这种多天线使用方式我们称之为MIMO(Multiple Input Multiple Output)。

MIMO可以非常有效的提升数据传输速度,理想情况下,对于上下行天线数目相同的MIMO设计(例如有M个收发天线),那么信道容量/最大数据传输速度可以提升M倍。

同时,MIMO也可以通过波束设计完成发射能量聚焦,从而提升接受信号能量,提升信噪比和基站覆盖范围。不过通常情况下这种方式所提升的覆盖范围会受到较为严重的障碍物衰减。

这种多天线设计需要对每个天线都赋予权重,才能因此提高空间复用增益。因此传统的大量无源天线需要转变为5G时代的有源天线,这会导致成本提升和能耗增加。

4G到5G的一个非常大的调整是采取了massive MIMO作为基站多天线解决方案。简单来说,Massive MIMO和MIMO这两者的区别就是字面意思,天线阵子的数目是不是足够大。

天线数目越大,就越有能力提供更多的信道自由度增益,这些增益可以用做空间分集,提高信号传输的可靠性,也可以用做空间复用,提高数据传输速度。同时,当天线数据大到一定程度时,天线的权重设计(预编码矩阵)的算法复杂度可以通过一些简单的线性算法得到很有效的解。

注:理论上来说,MIMO的天线数目多少会直接影响到可以发送或者接受的独立信息流数目(通常等于预编码矩阵秩),因此当我们描述MIMO系统时,通常会说到基站发射天线数量以及用户设备接受天线数量,比如4x4 MIMO代表在基站采用4个发射天线,手机采用4个发射天线,它会产生2个独立信息流(预编码矩阵秩为2)。

由于手机内部容量受限,对于sub 6G频段的终端天线数目增加难度很大,目前手机中sub 6G天线数目最多的是4个,而随着基站数目并不受限,它始终在不断提升。因此针对基站的MIMO系统存在另外一种表述方式:只描述发射天线数目,比如目前所说的MIMO 32TR是指基站拥有32个发射(Tx)信道和32个接收(Rx)信道。通常我们认为5G中用于 sub 6G 的massive MIMO应当大于16TR,目前主流有16TR、32TR和64TR几种配置。

同时,在目前5G所采用的两种频段(sub 6G和毫米波)中,massive MIMO的使用方式和目的都有所不同。在sub 6G宏基站中,massive MIMO主要目的是尽量提供更多的复用增益,也就是尽量提供更多的独立数据流给各个用户,我们通常称这种工作场景为多用户MIMO(MU-MIMO);而毫米波基站中,massive MIMO的主要目的是提高基站覆盖范围,弥补路径损耗,提高单个用户的信噪比和空间增益,我们通常称这种工作场景为单用户MIMO(SU-MIMO)。这两种目的决定了波束赋形和预编码的算法设计和硬件设计都略有不同。

对于设备商来说,Massive MIMO基站的设计也遇到了成本问题:当天线阵子数目增加之后,单个基站的射频信号处理链路(RF chain)数目也会随之增加,这会导致单个基站的成本大幅度攀升。特别是毫米波基站覆盖范围小,这种现象会更为严重。目前普遍的做法是采用模拟-数字混合链路设计方案来代替原本的纯数字链路设计,以达到降低成本的目的。

Massive MIMO 可以非常有效的提高用户数据传输速率和基站覆盖范围,也能提升单个基站的用户容量。

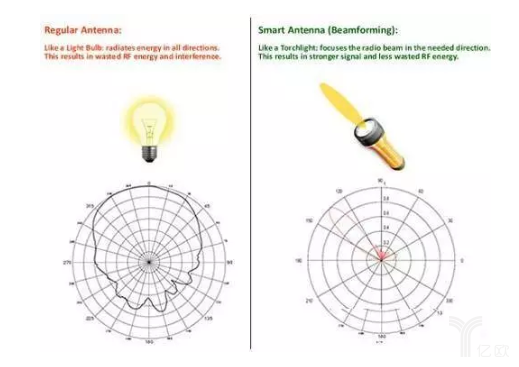

然而多天线所形成的波束经过设计(波束赋形)之后虽然能量会上升,同时覆盖范围会上升,但是单个波束的照射区域大小却会下降。它们之间的对比就像电灯泡和手电筒。

这种情况下,用户可能仅仅数米就能走出波束的照射范围;更重要的问题是,低照射范围会面带来用户接入问题。

注:在sub 6G基站中,因为同小区内可能会存在多个波束用来服务不同用户;当2个或者2个以上波束照射区域重叠时,同频用户会发生波束间干扰;甚至当用户接入此基站时,也需要鉴别自己接入的是波束序号,以确定自己的资源分配方案。

因此,如何正确管理和切换Massive MIMO小区中波束,是另外一大4G和5G的不同。因为这个问题与传统的4G小区切换和初始接入相同,所以有人称5G中massive MIMO会导致传统小区分裂为多个扇状小区。

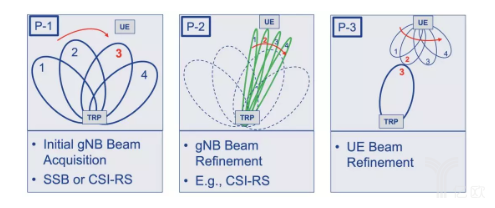

波束管理的目的是为了中确认并维持一个或多个用户-基站间的可用波束,它需要确定适合当前用户的最佳波束、测量用户与基站之间的信道状态、调整massive MIMO中的波束成型算法以跟踪用户。当用户存在另外的最佳波束时,对用户做出波束切换。

而当用户接入时,初始接入就是波束管理的第一步。

当一个用户在另一个sub6G基站范围内出现时(不考虑小区切换),会启动初始接入阶段。这个阶段大致分为三步,波束扫描同步信号和小区信息、用户发起随机接入请求并微调基站波束朝向、用户微调自身接收完成波束匹配和绑定。这样单个用户在基站范围内就拥有了特定的波束来追踪用户轨迹,提供通信服务。

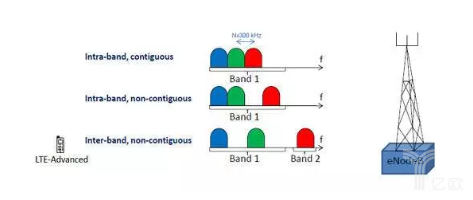

上文中有提到,LTE-A系统中采用载波聚合来提升单个用户可获得的带宽,通过允许用户在多个载波上同时传输数据来提升峰值数据速率。其实载波聚合中最简单的应用场景是在相同的工作频段中使用连续子载波(带内连续载波)进行聚合。但是这并不普遍适用,很多情况下,LTE系统中聚合的是带外非连续载波。

注:LTA-A中支持最大5载波聚合,提供100MHz的可用带宽,而LTA-A Pro中支持最大32载波聚合,提供640MHz的可用带宽。

而3GPP中定义的载波聚合只能允许单用户在对来自同一基站的载波进行聚合,当有来自2个基站的载波时需要同时接收时,这种方式被称为双连接(Dual Connectivity)。双连接可以允许用户同时在来自两个不同基站的多个载波上同时传输和发送数据,这两个基站分别被称为主基站和第二基站。

注:因为5G中将会采用多种频谱覆盖同一区域,同时会将控制数据和用户数据分离,这会导致异构小区大量存在,在这种情况下采用双连接来连接宏基站和微基站是非常必要的。

在5G部署初期的非独立组网(NSA)阶段,5G基站将会锚定在4G系统中,而LTE系统和5G NR系统频段不同,基站也不同。这时候可能会采用双连接来同时处理来自eNB和gNB的多频段载波信息。

从目前来看,载波聚合和双连接均会被用在5G NSA组网中。理论上5G NR的载波聚合可以获得高达1GHz频谱,同时传输不同帧的数据,同时也能加快5G中NSA网络的部署(仅仅需要添加5G基站,不需要过多更改4G核心网)。

在所有数字通信系统中,信道编码和译码都是提高数据传输可靠性的重要组成部分。数字信号在传输过程中总会因为信道失真、噪声和干扰等影响,导致接收信号后译码产生误差,达不到实用要求。

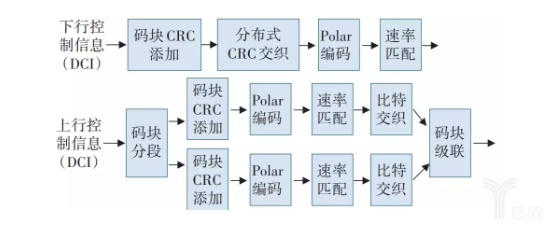

香农第二定理告诉我们,只要数据传输速率小于信道容量,就会存在一种编码,使误码率任意小。5G中新采用的LDPC码和Polar码就是目前性能优异的信道编码方案之二,它们都属于线性分组码。

实际上当时5G中信道编码的候选方案有四种,其中三种毕竟有竞争力:接近香农极限的Turbo码、LDPC码和达到香农极限的Polar码。

注:2G、3G、4G时代一直在采用Turbo码,而LDPC码在WiFi、固定通信等场景中得到使用,Polar码则是近些年编码领域的新星。

由于信道编码是物理层最基本的技术,信道编码方案对系统的性能有直接影响。在20Gbit/s的峰值速率要求目标下,系统对用户面和控制的延迟要求很高,信道编码的译码器单次译码延迟需要控制在几到几十s以内,同时要求译码器有合理的芯片面积和功耗。

根据5G系统对可靠性的要求,需要在eMBB场景在块误码率以上没有错误平层,在URLLC场景场景在块误码率以上没有错误平层。这个要求Turbo码很难满足,而且它的算法复杂度过高,虽然可以采用并行架构提升编译速度,但是随之而来的功耗提升和芯片计算能力要求也不利于实际使用。所以Turbo码是需要在5G标准中替换的。

Polar码是2009年由Erdal Arikan教授提出的新型线性分组码,主要是采用信道极化思想,利用极化而来的“理想信道”传输未知信息比特,利用“非理想信道”传输已知信息比特。对于这种方式,一些同学把它形象称为“放弃差生,提升优等生”。在诺基亚的研究中证明,Polar码在短码领域也存在显著的算法复杂度提升,它的算法复杂度要远远优于Turbo码和LDPC码,是短码中最优编码方案之一,目前被作为5G中控制信道的数据传输方案。

注:3GPP目前采用循环冗余校验(CRC)辅助的Polar码方案,使Polar码获得接近甚至在短码上超过Turbo和LDPC码的纠错能力。在无线通信常用的中长码配置下,能够获得大约0.5dB的增益;短码配置下甚至能够获得大于1dB的增益。

而LDPC码是1963年由Robert Gallager提出,它是根据奇偶校验矩阵来定义的一种线性分组码,通过稀疏非系统矩阵校验码块,并最终根据判决准则判断码字。

相比Turbo码,LDPC码具有较小的译码错误和译码复杂度,且码长大于200时无错误平层,并且可以实现并行操作,有利于硬件实现,且在长码字时算法复杂度优于Polar码,所以它被票选为5G中数据信道的传输方案。

学通信的同学应该都对正交频分复用(OFDM)有相当深刻的印象,OFDM是目前主流通信标准都在采用的波形,包括3GPP LTE和IEEE 802.11(Wi-Fi)系列。当它被用作多址接入时,被称作正交频分多址接入(OFDMA)。

在LTE系统中,上行链路采用的是采用的是采用循环前缀的离散傅里叶变换-扩频OFDMA(DFT-s-OFDMA),下行链路采用的是单载波频分复用(SC-FDMA)。不得不说,SC-FDMA其实并不先进。

实际上,传统的带有循环前缀的OFDM因为传输效率高,实现简单,与MIMO系统天然适合等优点,但是OFDM系统普遍要求精确的时钟同步来维持载波间的正交性,在实际应用中,普遍采用的方案是增加更多的时间同步信号和循环前缀来保证载波同步,这样却会带来更多的时间开销,这不利于5G中低延迟目标的实现;同时OFDM的带外辐射过高,峰均比过大等问题也需要解决。

因此,各个通信厂商提出了滤波正交频分复用(Filtered-OFDM.f-OFDM)、滤波器组OFDM(FB-OFDM)等波形,来获得更高的时频效率和更好的带外辐射特性,以满足5G通信要求。目前华为提出的f-OFDM是呼声最高的一种选择。

目前MIMO技术已经在5G系统中得到了广泛使用,FB-OFDM虽然带外衰减性能最好,但是与MIMO不宜结合,所以目前处境比较困难[5]。我们这就重点介绍一下f-OFDM技术。

顾名思义,f-OFDM主要采取的措施是在发送前对OFDM信号进行滤波处理,这样的好处是可以获得更加灵活的信号设计方案,可以配置载波间隔、循环前缀、滤波器系数等参数,来满足5G的多样性需求和一种特殊的要求--软件定义空口。此外,f-OFDM也集成了OFDM中复杂度低、频谱效率高等优点,也可以通过配置克服OFDM中带外辐射高、帧结构固定等问题,甚至能通过DFT预编码来克服OFDM的均峰比过高的问题。

注:3GPP 86次RAN会议上讨论并仿真了再新的PA模型下f-OFDM和OFDM的系统性能,结果显示在3个用户功率平均分配,保护间隔为12个子载波时,f-OFDM会获得1dB的性能提升。

为了获得上述优点,f-OFDM所需要付出的仅仅是增加几个可配置滤波器,所以说f-OFDM是目前呼声最高的一种选择。

此外,很多人认为OFDM波形用于多址接入很可能不能满足mMTC场景多址接入的需求,因此3GPP RAN1 在 2016 年中的会议决定:eMBB 场景 的多址接入方式应基于正交的多址方式(OFDMA),非正交的多址技术只限于 mMTC 的上行场景。

这样非正交频分多址(NOMA)也成为了一种研究热点,吸引了大量目光。华为的SCMA、中兴 MUSA 和大唐的 PDMA 等将在Release 16中竞争 mMTC 的上行多址方案。

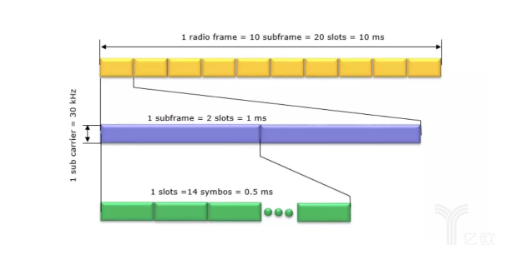

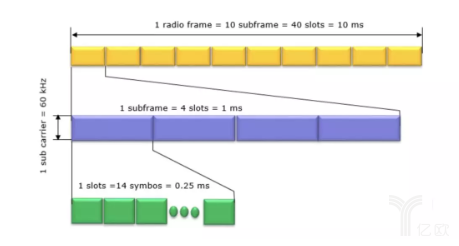

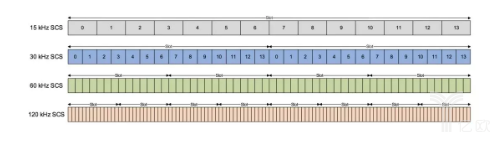

对比4G LTE,5G中最突出的配置是可变的numberology(符号长度和子载波间隔),因为可变命理,所以5G的帧结构可根据场景变化,且更加灵活,甚至因此可以为不同场景配置不同带宽。5G的命理(numberology)已经在3GPP 38.211中确定,所以这里可以详细聊一聊。

在5G中,numberology主要由一个特定参数μ来代表,一般与子载波间隔间的换算关系是 KHz,当μ为0时,是最基础的子载波15KHz,具体的配置如下表所示:

如上所述,在5G/NR中支持多种numberology,并且根据numberology类型的不同,无线电帧结构略有不同。然而,不管numberology和μ如何,一个无线电帧的长度和一个子子帧的长度是相同的。无线电帧的长度总是10毫秒,子帧的长度总是1毫秒。

那它们为什么帧结构不同呢?

主要是因为每个子帧中的slots数目不同,以及slots中的OFDM符号数目不同。我们以正常循环前缀,μ为1时,子载波间隔30kHz这个配置为例。此时每个无线电帧中有10个子帧,每个子帧中有2个slots,而每个slots由14个OFDM符号组成,这样每个slots长度1ms/2=0.5ms。

当正常循环前缀,μ为2时,子载波间隔是60kHz,此时每个无线电帧中有10个子帧,每个子帧中有4个slots,而每个slots由14个OFDM符号组成,这样每个slots长度1ms/4 = 0.25ms。

以此类推。

具体的帧长度配置可以查阅38.211-4.3.2-1表。

可变帧长度和可变命理使得5G的帧结构在毫米波、sub6G频段均可通用,且为跨频段的载波聚合和双连接奠定了基础,也使5G在URLLC场景可以通过更改帧结构,获得更低的延迟,在eMBB场景获得更多的子载波带宽,为以后的扩展奠定了基础。

5G中帧结构的另一个改变是采用了极简载波的概念。

正如之前所说,LTE系统需要每10ms启用一次广播信号(红色部分),每5ms启用一次同步信号(图中蓝色为Primary synchronization,浅蓝色为Secondary synchronization),同时,LTE系统需要大量的小区参考信号(图中黑点)。5G中,因为可能采用更好的波形和更好的硬件,对OFDM信号正交性的要求降低,因此降低了同步要求,同时在把信令压缩,取消了所有的小区参考信号,每20ms同步和广播一次。

这种极简载波设计极大的降低了信令开销,降低了延迟。

在5G的设计中,需要支持物联网、语音、通话等等多种业务,而不同的业务场景对网络要求差异非常明显,不同业务指标需要的资源也完全不同,而且其中的一些参数是无法兼顾的。具体见下图:

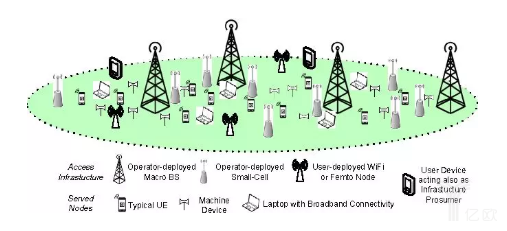

如果想要在一张网络中同时支持多种场景,那么最好的方式是不同业务采用配置不同的网络路径,经过不同网元,这种技术被称为网络切片(Network Slicing)。那么很容易理解,网络切片的先决技术是需要能够通过软件控制各个不同的网元,也就是网络虚拟化或者被称为软件定义网(NFV/SDN)。

其实SDN已经在4G LTE网络中得到了很多广泛的应用,也已经比较成熟。SDN/NFV通过把传统的网络单元(MME、PCRF、P/S-GW)和基站(接入网单元,C-RAN)替换为放在机房中的虚拟机池,并通过软件控制。

注:这里的机房可能放置在大型数据中心中(核心云),也可能放置在小型城镇的数据中心或者小型区域中(边缘云)。当基站的控制单元被放入机房,外部只留下AAU时,这些控制单元被称作云接入网(C-RAN)。

这种方式可以带来很多好处,比如核心网络的功耗可以通过数据中心的集中管理得到控制,比如可以针对不同的业务配置不同的服务质量标准(QoS)等等。实际上,网络单元的云化和虚拟化也是大势所趋,能极大的降低运营商的运营成本,这也是运营商的根本利益。所以移动、联通和电信等运营商对SDN、NFV和C-RAN等网络虚拟化技术有很高的渴望。

狭义来说,5G仅仅是一个跨越物理层和MAC层的无线通信技术合集,定义了一个无线通信系统,而系统中的各种技术应用都是牵一发而动全身的,比如因为网络虚拟化的应用,5G波形很有可能会采用f-OFDM来获得更灵活的空口配置,实现软件定义空口这个概念;比如因为新型波束的采用,信令部分可以放宽对时间同步的要求,从而采用更简化的信令设计;比如因为massive MIMO的采用,基站接入部分就需要制定良好的波束管理和新的初始接入方案;而因为毫米波基站和小区覆盖的下降,又带来两个新特性:

超密集网络部署和微波接收回传一体化

现实中,因为5G即将采用的毫米波传输和sub 6G基站的覆盖范围都远不及4G时代,所以基站密集部署(Ultra Dense Deployment)将会是一个现实情况;运营商需要通过缩短各个发射节点之间的距离,改善网络覆盖范围,以促使终端在热点区域获得更多频谱,并让用户在边缘区域也获得更好的性能。

当用户同时被多个基站覆盖时,就会因为子载波频段被同时占用而存在可能的小区间干扰问题,超密集网络会带来更严峻的小区间干扰挑战,网络异构也将会成为未来的现实。

不过超密集网络也存在一些好处,比如因为毫米波基站的大带宽,所以从从核心网络到基站部分的数据传输(前传和回传)有可能通过闲置的毫米波频带,通过毫米波基站接力来完成,传统的前传解决方案是纯光纤前传,在国外的一些无法部署光纤地区,存在微波回传基站。

这种技术,我们称为微波接收回传一体化。有望可以降低运营商承载网络的组网成本。

边缘计算

5G中为了使网络虚拟化,在接入网采用了C-RAN技术,它将基站控制单元放置在基带池中,那么基带池就成为了一个天然的小型数据中心。这样的小型数据中心有能力为基站池所服务的范围内用户提供一些计算/储存等缓存。这种方式我们成为边缘计算。

边缘计算可以创造出一个高性能、较低功耗、低延迟和高带宽的电信级网络服务环境,可以被扩展为城镇级或者小区级的小型数据中心。它可以解决很多亟需低延迟的应用问题,比如云游戏。

运营商本身也能通过边缘计算扩展自身的业务范围,提供超低延迟的特殊云服务,而不是仅仅局限于担当单一的传输管道。